软件测试人员对 RUP 四个阶段的贡献:另一种观点(3)

评估进展

RUP 提到的迭代节奏到构建阶段还是活跃着的,并且该频率与测试人员有特别的关系。测试人员的主要目标是能够客观地描述系统的当前状态,并且能够将该状态与以前的状态进行比较。这两个状态之间的区别,简单地说,就是进展。

测试人员的“节奏”源于以下活动。

测试设计和实现

测试人员的一项主要任务是测试脚本的设计和实现。在迭代开发中,这是由为当前迭代安排的场景所驱动的。测试脚本必须开发成能够将应用程序推到正确的“屏幕”或其他应用程序模式。测试数据必须开发成可以在此处执行应用程序,并且验证必须设计成可以核对应用程序的行为。

如果使用了自动化的测试工具,那么此时会提出某种考虑,关于该测试用例是否是好的自动化候选或者是否应该手动执行。

测试执行

执行测试来确定每个验证点的通过或失败状态。执行手动测试意味着有方法地遵守测试实现提示并适当地观察和注意结果。

执行自动化的测试意味着安排正确的系统初始条件,然后调用脚本回放工具。在控制初始条件时,我们希望管理测试过程中什么数据处于什么状态。该需求也适用于手动测试,区别在于测试人员可以“照顾”交互并且经常让测试不工作来工作于未初始化的开始条件周围。

回归和测试脚本维护

迭代开发的一个明确的任务是需要为每个新的迭代再次运行旧的测试。这种对现有测试集的重复执行称为回归测试,是一个显露出自动化测试的好处和负担的活动。好处:因为另一种是手动测试,很明显的耗费时间的活动。负担:因为自动化的脚本经常需要仔细的修改来服务于下一个构建。测试脚本维护,和脚本回放调试器,对测试人员来说将会是非常熟悉的。测试人员将会及早并且使用减少脚本退化的测试工具,了解如何减少维护工作。

缺陷跟踪和分辨

缺陷跟踪和分辨活动是测试人员都知道的。测试行为总是揭示缺陷或问题,并且必须勤奋地跟踪每个事故来进行分辨。首先,分辨通常需要在实验室中复制的错误,但至少是处于这个原因,即 SEI Capability Maturity Model Integration (CMMI) 要求项目团队实现配置管理以达到有威信的“可重复级别, 级别 2”。只有通过将所有开发文件置于该控制下,并且用材料清单描述每个构建,开发人员才可能有许多机会重复所有已知的事件并因此能够满足该标准。

为了提高项目角色之间缺陷信息的共享,用开发人员使用的同样的配置管理和缺陷跟踪环境来装备测试人员是合理的。

针对进展的量度

我们已经回顾了测试人员在构建阶段所做的事情。我们如何将其转化为进展的量度呢?有多种描述恰当的技术, 3 以下的处理是可以借鉴的。

完成百分比

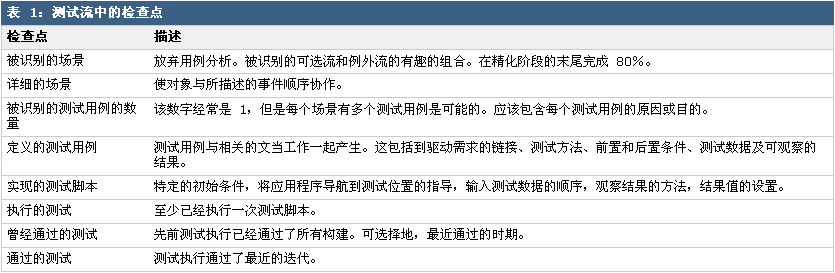

度量进展的一个过分简单但特别实际的方法是利用“完成百分比”作为量度。如果有人考虑通过测试的场景的流程,我们可以考虑构造一组检查点,表 1 中所显示的一个实例。

我们确定表 1 中每个场景和测试中所描述的每个检查点。不论完成或是没完成,它们的值都严格地报告为是或不是的值。我们合计每一层并将其表示为前一个层的某个百分比。目标是达到每一层的 100% 覆盖。总的结果相当粗略,但针对达到最高百分比的工作带来了提前测试工作的非常有意义的副加作用。

缺陷趋势

每个迭代将拥有一个开发包,一些新的特性或场景加入其中并且根据现有场景的缺陷也得到修复。当然有一个趋势,即实现新的而不修复老的,但是明智的项目经理将注意缺陷趋势并强调,至多一两个以缺陷形式的未解决的迭代工作的价值将保留。

无论如何,分辨缺陷无疑可以看作进展。与缺陷相关的量度也能够以有趣的方式得来,包括:

每个缺陷的工作、每行源代码的缺陷、每个模块或组件的缺陷、按照注入点的缺陷、按照时间的缺陷、按照状态的缺陷。

使用时间图表 —— 根据时间所有这些量度都可以画为图表趋势,例如,应该积极地调查表示修复缺陷工作稳定增长的趋势。

我们还能够通过余下的迭代的数量和平均的缺陷分辨工作来增加每个迭代的预期缺陷。这指示了显著的缺陷负担,包括在还没撰写的代码中没有发现的缺陷!这些是粗略的数字,但是是要求全部的完成百分比的重要基础。

对于测试人员的缺陷趋势

虽然上面的缺陷趋势不是具体到测试规程的,但是存在重要的缺陷量度来指导测试人员,包括每个找到的缺陷的测试工作、每个测试用例的缺陷、每个场景的缺陷,及每个迭代的缺陷。

这样的量度是有效的,不仅从历史的观察,还从预言能力上讲。例如,如果我们的测试揭示了一个突然的且出乎意料的缺陷密度,我们可能宣称该构建是不健全的,放弃测试,并让架构团队检查此构建。测试一个糟糕的构建以致精疲力尽,从中得不到一点好处。

MTBF

平均故障时间(mean time between failure,MTBF)是重要的“人造”量度 —— 也就是,我们不得不捏造定义,为了能够生成受控条件下的客观度量。MTBF 通常作为非功能需求出现。为了验证我们的系统,我们必须在实验室设置在测的应用程序,利用事件进行干扰,并且当不能适当处理事件时进行监测。我们将其记录为一个失败,并且继续测试或者(如果不幸的话)重新启动应用程序。我们能够以快于真实情况的节奏来生成事件流。这些手段的净效应是能够在几个星期内生成几年中才能度量出的 MTBF 数字。 因为明显的理由,可以将其认为是人造的量度。

这些量度证明测试人员应该看作是项目经理重要的数据来源。

构建迭代测试优先级

用例驱动的迭代方法生成了新的机会和新的负担。因为我们将已经限制阻碍完全测试的资源,所以我们应该根据以下优先级顺序执行测试:

运行“冒烟测试”。如果冒烟测试通过了,那么: